O TEMPO PODE EXISTIR APENAS NA SUA MENTE

Se alguém me dissesse que o tempo não existe, eu ia ficar bem irritada. Afinal de contas, tudo na nossa vida gira em torno dele: nossos compromissos, nossas memórias, nossos planos. Todas as pressões que enfrentamos no cotidiano, inclusive a de não perder tempo, apontam para seu efeito profundo.

Mas é exatamente isso que pesquisadores da Universidade de Harvard e do Instituto Astellas de Medicina Regenerativa estão sugerindo: que o tempo é algo completamente subjetivo e só existe na nossa cabeça.

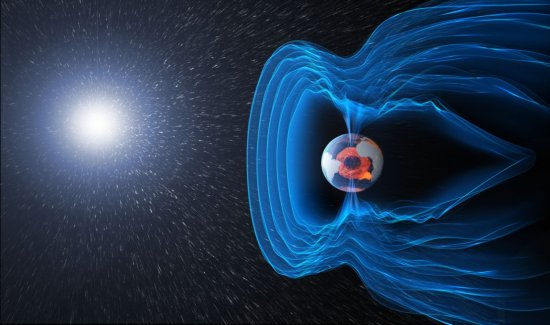

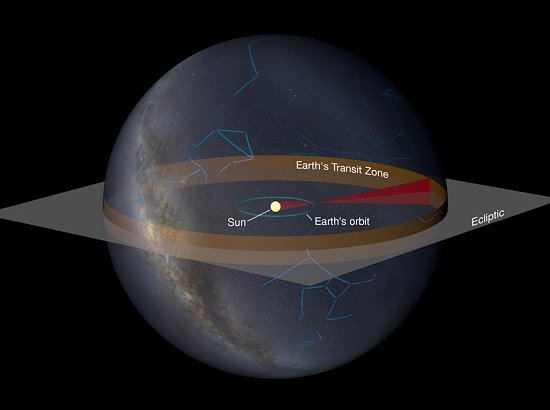

Seta do tempo

O novo estudo afirma que a gravidade não é forte o suficiente para forçar todos os objetos do universo para a frente – o que bagunça a teoria da “seta do tempo”.Graças à seta virada para a frente do tempo, o jovem torna-se velho, o passado torna-se o presente, etc. Você não pode “descozinhar” um ovo, certo?

Mas, se esquecermos a nossa própria perspectiva por um segundo, e olharmos para o universo como um todo, tanto quanto podemos dizer, a única coisa que governa o comportamento do universo são as leis da física.

E o problema é que todas, menos uma dessas leis, são reversíveis – o que significa que os mesmos efeitos ocorrem independentemente de se o tempo está correndo para a frente ou para trás. A gravitação de Newton, a eletrodinâmica de Maxwell, a relatividade especial e geral de Einstein, a mecânica quântica… Nenhuma dessas equações que melhor descrevem nosso universo depende do tempo.

Termodinâmica

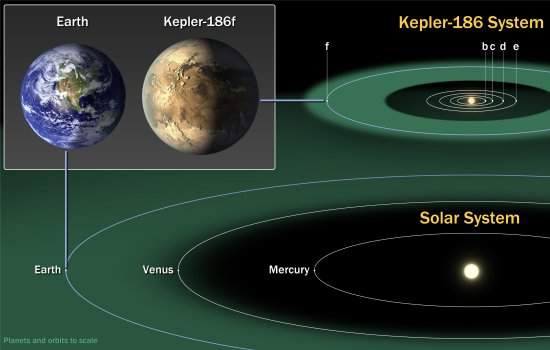

Um exemplo desta qualidade “reversível” do universo é o caminho de um planeta orbitando uma estrela, de acordo com a força da gravidade. Não importa se o tempo corre para a frente ou para trás, órbitas planetárias seguem exatamente os mesmos caminhos. A única diferença é a direção da órbita.Sendo assim, seria o tempo subjetivo?O sim seria definitivo, não fosse uma coisa chamada segunda lei da termodinâmica.

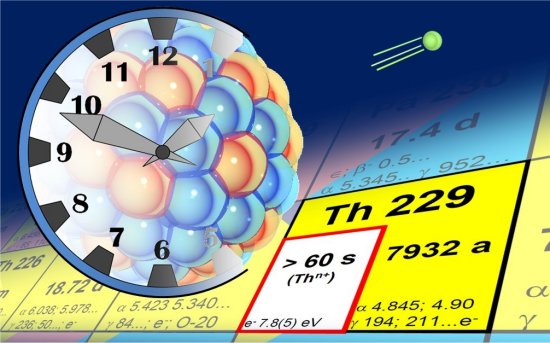

De acordo com a segunda lei da termodinâmica, conforme o tempo passa, a quantidade de desordem – ou entropia – no universo sempre aumenta. Isso explica os ovos cozidos – eles foram desordenados para ser cozinhados, e não podemos voltar atrás e diminuir a quantidade de distúrbio aplicada a um sistema particular.

Por esta razão, a segunda lei da termodinâmica pode ser considerada a fonte da seta do tempo.

Universos paralelos

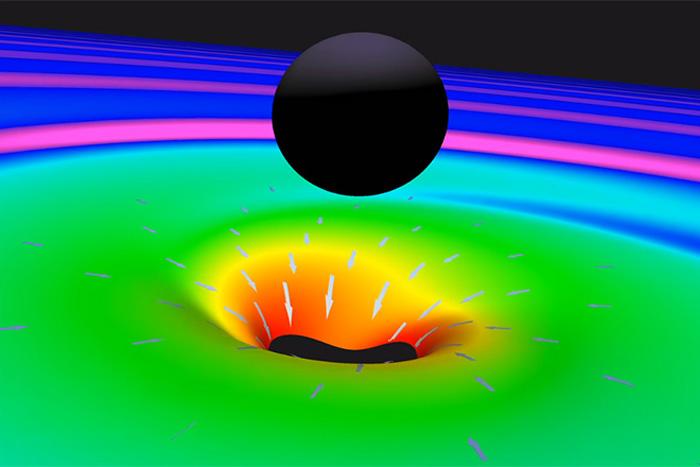

Muitos físicos suspeitam que, quando a gravidade força suficientes partículas minúsculas a interagir umas com as outras, a seta virada para a frente do tempo emerge, e a entropia pode aumentar.As regras, em seguida, mudam para favorecer um universo mais “sem direção”, uma vez estas partículas minúsculas começam a interagir com coisas muito maiores.

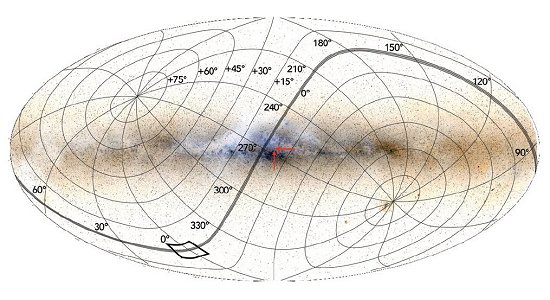

Mas, para que isso funcione, a entropia deve ter aumentado, o que significa que o universo tinha que ter começado mais ordenado do que é agora – algo que alguns físicos têm tentado explicar ao sugerir que existem universos paralelos onde o tempo corre para a frente, para trás, para os lados, para qualquer direção.

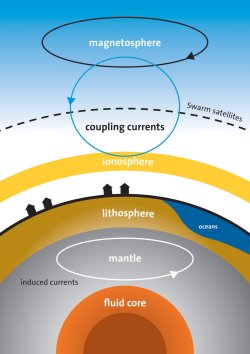

Decoerência

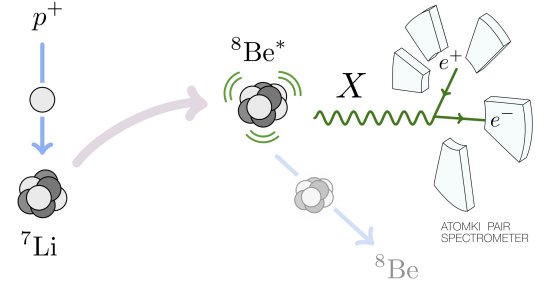

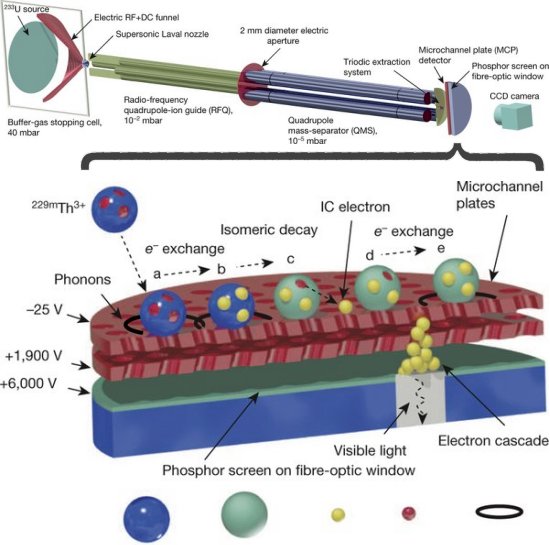

Em um esforço para chegar ao fundo de um dos maiores enigmas da ciência moderna, dois físicos decidiram testar a hipótese de que a gravidade é a força por trás de toda essa loucura.O ponto em que as partículas fazem a transição de ser governadas pela seta do tempo a ser regida pelas leis sem direção do universo é conhecido como decoerência.

A hipótese mais proeminente para explicar a decoerência é a equação Wheeler-DeWitt, que prevê que as “costuras” entre mecânica quântica e clássica são apagadas graças à gravidade.

Mas quando os físicos Dmitry Podolsky, da Universidade de Harvard, e Robert Lanza, do Instituto Astellas de Medicina Regenerativa, fizeram medições da gravidade através da equação de Wheeler-DeWitt, eles descobriram que ela não explica como a direção do tempo emerge.

Na verdade, de acordo com os seus resultados, os efeitos da gravidade são lentos demais para explicar uma seta universal de tempo.

Subjetividade

Se a gravidade é muito fraca para ser a coisa que segura uma interação entre moléculas conforme elas fazem a transição – a decoerência -, não pode ser forte o suficiente para forçá-las na mesma direção de tempo.“Nosso trabalho mostra que o tempo não existe, mas sim é uma propriedade emergente que depende da capacidade do observador de preservar informações sobre acontecimentos vividos”, explica Lanza para o portal Discover Magazine.

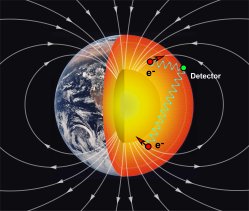

Isto sugere que a seta do tempo é subjetiva e determinada pelo observador. “Em seus trabalhos sobre a relatividade, Einstein mostrou que o tempo existe em relação ao observador. Nosso papel dá um passo adiante, argumentando que o observador, na verdade, cria o tempo”, Lanza disse ao portal Wired.

Polêmica

A ideia é, naturalmente, controversa. Outros cientistas, como o físico Yasunori Nomura, da Universidade da Califórnia em Berkeley, apontam falhas no estudo, como o fato de que a dupla não levou em conta o tecido do espaço-tempo, e que introduziu uma qualidade na equação – “tempo do observador” – que ninguém sabe se é de fato real.“A resposta depende se o conceito de tempo pode ser definido matematicamente sem incluir observadores no sistema”, argumenta Nomura.

Ainda não podemos explicar a estranheza do tempo no universo, mas Lanza e Podolsky indicam que talvez não estejamos considerando sua natureza subjetiva.